学习本地部署Qwen2.5-Coder,提升编程效率。

Qwen2.5-Coder的推出,标志着智能代码语言模型进入了新的时代。这款模型具有高效性能和实用价值,不仅能够深入理解复杂的代码结构,还能提供精确的代码补全和错误检测,极大提升开发效率。

本文详细介绍如何在本地系统上部署Qwen2.5-Coder,以及其与Ollama的集成方案,希望为开发者带来更流畅的开发体验。

1、Qwen2.5-Coder架构概览

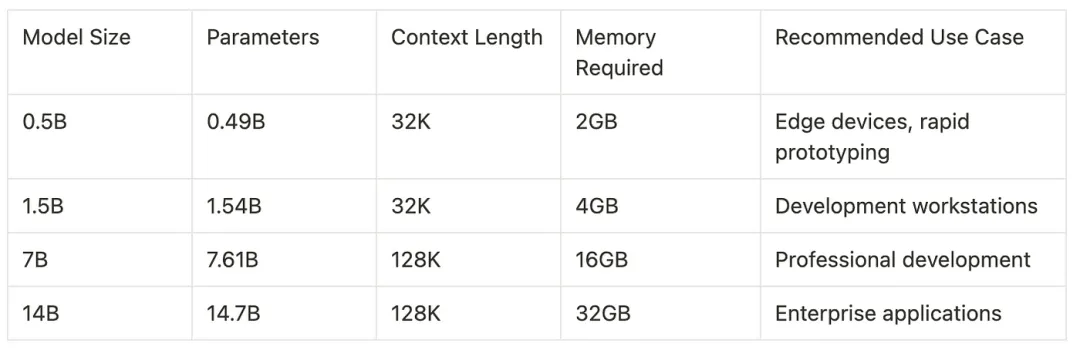

Qwen2.5-Coder的架构是在前代模型的基础上发展而来,在提升模型效率和性能方面实现了重大突破。该模型系列提供了多种规模版本,以适应不同的应用场景和计算资源限制。

Qwen2.5-Coder采用了先进的变换器架构,通过增强的注意力机制和精细的参数优化,进一步提升了模型的整体表现。

2、设置Qwen2.5-Coder与Ollama集成

Ollama为在本地运行Qwen2.5-Coder提供了一种简洁高效的解决方案。以下是详细的设置过程:

3、Qwen2.5-Coder 性能分析

性能基准测试显示,Qwen2.5-Coder在多种编程任务中展现了优秀的能力。该模型在代码补全、错误检测和文档生成等方面表现尤为突出。在配备NVIDIA RTX 3090的消费级硬件上,7B模型在代码补全任务中的平均推理时间为150毫秒,同时在多种编程语言中保持了高准确性。

4、使用 Python 实现 Qwen2.5-Coder

以下是一个使用Python结合Ollama的HTTP API来实现Qwen2.5-Coder的示例:

Qwen25Coder5、性能优化与高级配置

在生产环境中部署Qwen2.5-Coder时,采用一些优化策略可以显著提升其性能。以下是使用Ollama高级功能的详细配置示例:

此配置启用了几个重要的优化:

- 自动张量并行处理:针对多GPU系统,实现自动张量并行处理。

- Int8量化:通过Int8量化减少内存占用。

- 基于Redis的响应缓存:使用Redis作为缓存,提高响应速度。

- Float16计算:采用Float16计算类型,提升计算性能。

- 优化线程和批量大小:调整线程数和批量大小,以达到最佳性能。

通过这些配置,Qwen2.5-Coder能够在保持高性能的同时,优化资源使用,适合在生产环境中稳定运行。

6、集成到开发工作流程中

Qwen2.5-Coder 可以通过各种 IDE 插件和命令行工具无缝集成到现有的开发工作流程中。

7、性能监控与调优

在生产环境中,为了达到最佳性能,进行有效的监控是必不可少的。以下是性能监控的示例设置:

此监控实现能够提供模型性能的详细数据,包括推理时间、内存使用和执行成功率等关键指标。利用这些数据,我们可以对系统资源进行优化,并识别出潜在的性能瓶颈。

8、展望未来与生态建设

Qwen2.5-Coder 生态系统在不断壮大发展着,计划在几个关键领域进行改进。即将推出的 32B 参数模型承诺在保持实际资源需求的同时增强能力。同时,开发社区也在积极研究针对特定编程语言和框架的专业微调方法。

该模型的架构旨在适应未来在上下文长度处理和内存效率方面的改进。当前,正在进行的关于更有效的注意力机制和参数优化技术的研究表明,未来的版本可能会以更低的资源需求实现更优的性能。

Qwen2.5-Coder 凭借着全面的功能集和强大的性能特征,代表了以代码为中心的语言模型的重大进步。无论是用于个人开发项目,还是作为企业级系统的集成部分,Qwen2.5-Coder都能提供强大的代码生成、分析和优化能力。与 Ollama 的结合使其特别适合本地部署,同时保持着专业级的性能表现。

本文转载自公众号AI科技论谈