前言

在数字化的浪潮中,Ollama如同一位技术界的“魔法师”,挥舞着它的魔杖——一行简单的命令,就能唤醒沉睡的代码巨人,一键本地部署2000+ 大模型!今天,让我们揭开Ollama的神秘面纱,一探究竟。

一、Ollama:AI“魔法师”

Ollama,它是一个轻量级、可扩展的大模型框架,就像是一位能够召唤各种大语言模型的魔法师。它不仅支持Windows、Linux、MacOS这些主流操作系统,还拥有一个庞大的模型库,包括Qwen、Llama等2000+大语言模型。

你只需轻轻一念咒语(输入命令),就能让这些模型为你所用,是不是很酷?

跨平台支持

Ollama就像是那个传说中的“万能钥匙”,无论你是在Windows的城堡、Linux的森林还是MacOS的岛上,都能轻松打开AI的大门。

丰富的模型库

提供了丰富的模型库,就像是给你一个巨大的“魔法书库”,里面藏有各种强大的魔法书(模型),你可以根据需要随时“借阅”。

自定义模型参数

支持用户上传自己的模型,就像是给你一个“魔杖”,你可以用它来调整魔法的效果,让魔法更符合你的心意。

多GPU并行推理加速

在多卡环境下,可以设置环境变量来指定特定GPU。这就像是给你的魔法书加上“加速咒”,让你的魔法施展得更快。

二、安装:简单到“真·一键搞定”

1、Windows安装

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Windows(Preview)”。

下载好以后,双击安装包,之后一直点击“install”安装即可。安装完成之后,打开一个cmd命令窗口,输入“ollama”命令,如果显示ollama相关的信息就证明安装已经成功了,如下图:

2、Mac安装

从下载页面,下载苹果系统相对应的安装程序,即点击“Download for Mac”。

下载好后,双击安装包,点击“install”,等待Ollama自动安装。

3、Linux安装

在Linux系统上,可以通过脚本安装或源码编译的方式来安装Ollama,下面介绍主流的脚本安装方法。

脚本安装

Ollama提供了一键安装脚本,可以快速在Linux系统上安装Ollama,打开终端,执行以下命令下载安装脚本:

curl -fsSL https://ollama.com/install.sh | sh

等待安装完成。安装脚本会自动下载所需的组件,并完成Ollama的安装与配置。安装完成后,可以通过以下命令启动Ollama:

ollama serve

三、命令参数:你的AI助手

以下是Ollama使用常见的指令:

ollama serve 启动ollama

ollama create 从模型文件创建模型

ollama show 显示模型信息

ollama run 运行模型

ollama pull 从注册表中拉取模型

ollama push 将模型推送到注册表

ollama list 列出模型

ollama cp 复制模型

ollama rm 删除模型

ollama help 获取有关任何命令的帮助信息

四、设置自定义模型下载路径

默认情况下,ollama模型的存储目录如下:

macOS: `~/.ollama/models`

Linux: `/usr/share/ollama/.ollama/models`

Windows: `C:\Users\<username>\.ollama\models`

Windows更改Ollama模型存放位置

在Windows系统中,若要更改Ollama模型的存放位置,可以按照以下步骤操作:

- 右键点击“此电脑”或“我的电脑”,选择“属性”。

- 在系统窗口中选择“高级系统设置”。

- 在系统属性窗口中点击“环境变量”按钮。

- 在环境变量窗口中,点击“新建”创建一个新的系统变量或用户变量。

- 变量名:OLLAMA_MODELS

- 变量值:输入你希望设置的新模型存放路径,例如:E:\Ollama\Models

- 点击“确定”保存设置。

- 重启Ollama相关服务,使新的路径生效。

Linux/Mac更改Ollama模型存放位置

在Linux或Mac系统中,更改Ollama模型存放位置的步骤如下:

- 打开终端,创建一个新的目录作为模型存放位置,例如:`mkdir -p /path/to/your/new/ollama/models`

- 在终端中运行以下命令:`source ~/.bashrc`(或者source ~/.bash_profile,取决于你编辑的文件)

- 重启Ollama相关服务,使新的路径生效。

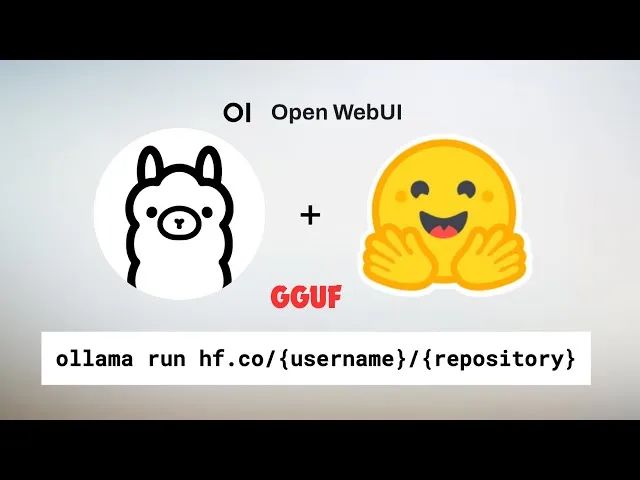

五、导入huggingface模型

最新版Ollama开始支持从Huggingface Hub上直接拉取各种模型,包括社区创建的GGUF量化模型。

用户可以通过简单的命令行指令快速运行这些模型,可以使用如下命令:

ollama run hf.co/{username}/{repository}

要选择不同的量化方案,只需在命令中添加一个标签:

ollama run hf.co/{username}/{repository}:{quantization}

例如:量化名称不区分大小写

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:IQ3_M

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:Q8_0

还可以直接使用完整的文件名作为标签:

ollama run hf.co/bartowski/Llama-3.2-3B-Instruct-GGUF:Llama-3.2-3B-Instruct-IQ3_M.gguf

如何系统的去学习大模型LLM ?

AI会取代那些行业谁的饭碗又将不保了?抢你饭碗的不是AI,而是会利用AI的人。科大讯飞、阿里、华为与其焦虑……

掌握AI工具的技术人但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高。

LLM大模型资料LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程

一、LLM大模型经典书籍

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套LLM大模型报告合集

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、LLM大模型系列视频教程

四、LLM大模型开源教程(LLaLA/Meta/chatglm/chatgpt)

LLM大模型学习路线 ↓

阶段1:AI大模型时代的基础理解

-

目标:了解AI大模型的基本概念、发展历程和核心原理。

-

内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

-

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

-

内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.3 流水线工程

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

-

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

-

内容:

- L3.1 Agent模型框架

- L3.2 MetaGPT

- L3.3 ChatGLM

- L3.4 LLAMA

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

-

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

-

内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

LLM大模型资料LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程